1. Các mô hình SNN

Một trong những câu hỏi quan trọng liên quan đến tính toán neuromorphic là sử dụng mô hình mạng nơ-ron nào? Mô hình mạng nơ-ron xác định những thành phần nào tạo nên mạng, cách các thành phần đó hoạt động và tương tác. Ví dụ, các thành phần phổ biến của mô hình mạng nơ-ron là các nơ-ron và khớp thần kinh (synapse), lấy cảm hứng từ các mạng nơ-ron sinh học. Khi xác định mô hình mạng nơ-ron, người ta cũng phải xác định các mô hình cho từng thành phần (ví dụ: mô hình nơ-ron và mô hình synapse); các mô hình thành phần chi phối cách thành phần đó hoạt động.

Làm thế nào để lựa chọn được một mô hình chính xác? Trong một số trường hợp, có thể mô hình đã chọn được thúc đẩy bởi một lĩnh vực ứng dụng cụ thể. Ví dụ, nếu mục tiêu của thiết bị thần kinh là sử dụng thiết bị để mô phỏng bộ não sinh học cho một nghiên cứu khoa học thần kinh ở quy mô nhanh hơn so với kiến trúc Von Neumann truyền thống, thì một mô hình sinh học thực tế và hợp lý là cần thiết. Nếu ứng dụng là một nhiệm vụ nhận dạng hình ảnh đòi hỏi độ chính xác cao, thì một hệ thống neuromorphic thực hiện các mạng nơ-ron tích chập có thể là tốt nhất. Bản thân mô hình cũng có thể được định hình bởi các đặc tính và/hoặc hạn chế của một thiết bị hoặc vật liệu cụ thể. Ví dụ: các hệ thống dựa trên vi điện trở nhớ (memristor) có các đặc điểm cho phép các cơ chế giống như độ dẻo phụ thuộc vào thời gian tăng vọt (spiking-time) thích hợp nhất cho các mô hình mạng nơ-ron tăng vọt – SNN. Trong nhiều trường hợp, việc lựa chọn mô hình hoặc mức độ phức tạp của mô hình thực sự không hoàn toàn rõ ràng. Một loạt các kiểu mô hình đã được thực hiện trong các hệ thống phần cứng mạng nơ-ron hoặc neuromorphic. Các mô hình bao gồm từ mô hình chủ yếu lấy cảm hứng từ sinh học đến mô hình chủ yếu dựa trên tính toán. Các mô hình sau này được lấy cảm hứng từ các mô hình mạng nơ-ron nhân tạo hơn là bởi các bộ não sinh học.

1.1. Các mô hình nơ-ron

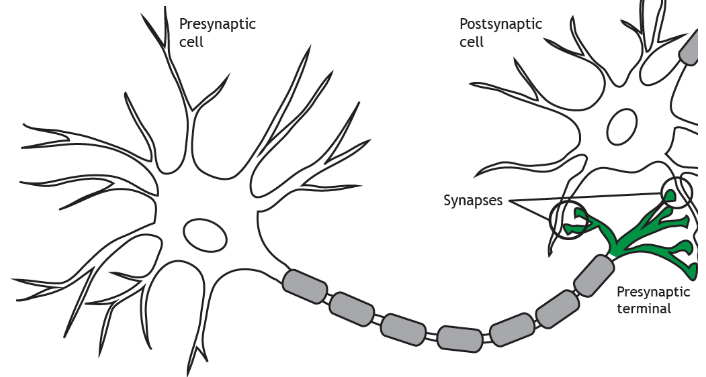

Một tế bào thần kinh (nơ-ron) sinh học thường bao gồm thân tế bào, sợi trục (axon) và đuôi gai (dendrite) như Hình 1. Sợi trục thường truyền thông tin từ nơ-ron và là nơi các nơ-ron truyền ngõ ra. Các đuôi gai thường truyền thông tin đến thân tế bào và thường là nơi nơ-ron nhận ngõ vào. Nơ-ron có thể nhận thông tin thông qua truyền bằng hóa chất hoặc điện từ các nơ-ron khác. Chỗ nối giữa phần cuối của sợi trục của một nơ-ron này và đầu gai của một nơ-ron khác cho phép truyền thông tin hoặc tín hiệu giữa hai nơ-ron được gọi là khớp thần kinh (synapse). Hành vi điển hình của nơ-ron là tích lũy điện tích thông qua sự thay đổi điện thế trên màng tế bào do nhận tín hiệu từ các nơ-ron khác thông qua khớp thần kinh. Điện thế trong một nơ-ron có thể đạt đến một ngưỡng cụ thể, điều này sẽ làm cho nơ-ron “phát hỏa (fire)” hoặc theo thuật ngữ sinh học là tạo ra một điện thế hoạt động di chuyển dọc theo sợi trục của nơ-ron để ảnh hưởng đến điện tích trên các nơ-ron khác thông qua các synapse.

Hầu hết các mô hình nơ-ron được thực hiện trong hệ thống neuromorphic đều có một số khái niệm về sự tích lũy điện tích và kích hoạt để ảnh hưởng đến các nơ-ron khác, nhưng cơ chế mà các quá trình này diễn ra có thể khác nhau đáng kể giữa các mô hình. Tương tự, các mô hình không hợp lý về mặt sinh học (tức là các mô hình nhân tạo lấy cảm hứng từ khoa học thần kinh chứ không phải bắt chước khoa học thần kinh) thường không triển khai sợi trục hoặc đuôi gai, mặc dù có một vài trường hợp ngoại lệ.

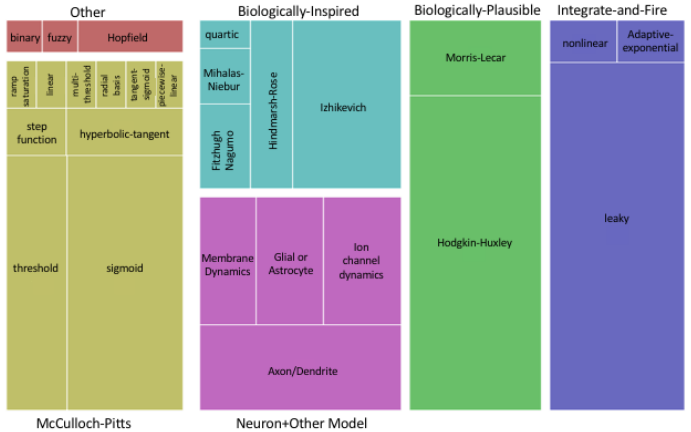

Các mô hình nơ-ron được chia thành năm loại lớn, theo Hình 2:

- Hợp lý về mặt sinh học (Biologically-plausible): Mô hình hóa rõ ràng các kiểu hành vi được thấy trong các hệ thống thần kinh sinh học.

- Lấy cảm hứng từ sinh học (Biologically-inspired): Cố gắng tái tạo hành vi của các hệ thần kinh sinh học nhưng không nhất thiết phải theo cách hợp lý về mặt sinh học.

- Nơ-ron và các mô hình cảm hứng từ sinh học khác: Mô hình nơ-ron bao gồm các thành phần khác được lấy cảm hứng từ sinh học thường không có trong các mô hình nơ-ron neuromorphic khác, chẳng hạn như sợi trục, đuôi gai hoặc nơ-ron đệm.

- Tích hợp và kích hoạt (Integrate-and-fire): Một mô hình đơn giản hơn của các mô hình nơ-ron tăng vọt về mặt cảm hứng sinh học.

- McCulloch-Pitts: Các mô hình nơ-ron là dẫn xuất của nơ-ron McCulloch-Pitts ban đầu [2, 3] được sử dụng trong hầu hết các tài liệu về mạng nơ-ron nhân tạo. Đối với mô hình này, đầu ra của nơron j được điều chỉnh bởi phương trình:

Với yi là giá trị ngõ ra, f là hàm kích hoạt, N là số ngõ vào vào neuron j, wi,j là trọng số của synapse từ nơ-ron i đến nơ-ron j, xi là giá trị ngõ ra của nơ-ron i.

Một loạt các mô hình nơ-ron lấy cảm hứng từ sinh học và hợp lý về mặt sinh học đã được thực hiện trên phần cứng. Các thành phần được đưa vào trong các mô hình này có thể bao gồm: Động lực học màng tế bào, chi phối các yếu tố như rò rỉ điện tích qua màng tế bào của nơ-ron; động lực học kênh ion, chi phối cách các ion di chuyển vào và ra khỏi nơ-ron, thay đổi mức điện tích của nơ-ron; mô hình trục, có thể bao gồm các thành phần trễ; và các mô hình đuôi gai, chi phối số lượng nơ-ron trước và sau khớp thần kinh ảnh hưởng đến nơ-ron hiện tại. Mô hình Izhikevich [4] đưa ra một cái nhìn tổng quan về các loại mô hình nơ-ron tăng vọt này.

a. Mô hình hợp lý về sinh học: Mô hình nơron hợp lý về mặt sinh học phổ biến nhất là mô hình Hodgkin-Huxley [5]. Mô hình này được giới thiệu lần đầu tiên vào năm 1952 và là một mô hình nơ-ron tương đối phức tạp, với các phương trình vi phân phi tuyến bốn chiều mô tả hoạt động của nơ-ron về sự truyền các ion vào và ra khỏi nơ-ron. Do tính hợp lý về mặt sinh học của chúng, nên các mô hình Hodgkin-Huxley, vốn đã rất phổ biến trong các triển khai neuromorphic, nỗ lực mô hình hóa chính xác các hệ thống thần kinh sinh học. Một mô hình đơn giản hơn, nhưng vẫn khả thi về mặt sinh học là mô hình Morris Lecar [6], mô hình này rút gọn mô hình thành một phương trình phi tuyến hai chiều. Nó là một mô hình được thực hiện phổ biến trong khoa học thần kinh và trong các hệ thống thần kinh sinh học.

b. Mô hình lấy cảm hứng về sinh học: Có nhiều mô hình nơ-ron là phiên bản đơn giản hóa của mô hình Hodgkin-Huxley đã được triển khai trong phần cứng, bao gồm mô hình Fitzhugh-Nagumo [7 – 9] và mô hình Hindmarsh-Rose [10, 11]. Các mô hình này có xu hướng đơn giản hơn về mặt tính toán và số lượng thông số, nhưng chúng trở nên dựa trên cảm hứng sinh học hơn là hợp lý về mặt sinh học bởi vì chúng cố gắng mô hình hóa hành vi thay vì mô phỏng hoạt động về mặt vật lý trong các hệ thống sinh học. Từ quan điểm của phần cứng tính toán neuromorphic, tính toán đơn giản hơn có thể dẫn đến việc triển khai đơn giản hơn, hiệu quả hơn và có thể được thực hiện với một phiên bản nhỏ hơn. Từ góc độ thuật toán và phương pháp học, một số lượng tham số nhỏ hơn có thể dễ dàng hơn trong việc thiết lập hoặc huấn luyện so với các mô hình có số lượng tham số lớn. Mô hình nơ-ron tăng vọt Izhikevich được phát triển để giải thích các hoạt động kích hoạt và tăng vọt tương tự như suy luận từ mô hình Hodgkin-Huxley, nhưng với tính toán đơn giản hơn. Mô hình Izhikevich rất phổ biến trong các tài liệu neuromorphic vì tính đơn giản và khả năng tái tạo các hoạt động chính xác về mặt sinh học [12, 14]. Mihalas-Niebur là một mô hình nơ-ron phổ biến khác nỗ lực tái tạo các hoạt động kích hoạt và tăng vọt với một tập các phương trình vi phân tuyến tính [15]; mô hình này cũng có các triển khai về neuromorphic [16, 17]. Mô hình bậc bốn có hai phương trình vi phân phi tuyến tính mô tả hoạt động của nó, và cũng có thực thi trên hệ thống neuromorphic [18].

c. Nơ-ron và các mô hình cảm hứng từ sinh học khác: Các mô hình lấy cảm hứng từ sinh học khác cũng đang thịnh hành nhưng không thuộc các loại trên. Chúng thường có mức độ chi tiết sinh học cao hơn nhiều so với hầu hết các mô hình học máy và trí tuệ nhân tạo, chẳng hạn bao gồm động lực học của màng [19], mô hình động lực học kênh ion [20], sự kết hợp của các sợi trục và/hoặc mô hình đuôi gai [21], và tương tác nơ-ron đệm hoặc tế bào hình sao [22]. Đôi khi, các mô hình mới được phát triển cụ thể với phần cứng. Ví dụ, một mô hình nơ-ron với các phương trình lấy cảm hứng từ mô hình Fitzhugh-Nagumo, Morris Lecar, Hodgkin-Huxley, hoặc các mô hình khác đã được phát triển, nhưng các phương trình đã được cập nhật hoặc các mô hình được trừu tượng hóa cho phép dễ dàng thực hiện trong thiết kế VLSI công suất thấp [23], trên FPGA [24], hoặc trên công nghệ CMOS [25]. Tương tự, các nhà nghiên cứu khác đã cập nhật mô hình Hodgkin-Huxley để đưa vào những phát triển phần cứng mới, chẳng hạn như trên các transistor MOSFET [26, 28] hoặc transistor đơn điện tử (Single-electron Transistor – SET) [29].

d. Mô hình Integrate-and-Fire: Một tập hợp các mô hình nơ-ron tăng vọt đơn giản hơn thuộc họ Integrate-and-Fire, là một tập hợp các mô hình có mức độ phức tạp khác nhau từ tương đối đơn giản đến những mức độ phức tạp tiệm cận gần với mô hình Izhikevich và các mô hình phức tạp hơn lấy cảm hứng từ sinh học. Nói chung, các mô hình Integrate-and-Fire ít thực tế hơn về mặt sinh học, nhưng tạo ra đủ độ phức tạp trong hành vi để hữu ích trong các hệ thống nơ-ron tăng vọt. Mô hình Integrate-and-Fire đơn giản nhất duy trì mức độ tích dòng điện của các nơ-ron. Ngoài ra còn có một phương cách mở rộng việc triển khai đơn giản nhất bằng cách đưa một thuật ngữ “rò rỉ” vào mô hình trên – điện thế trên một nơ-ron giảm dần theo thời gian. Nó là một trong những mô hình phổ biến nhất được sử dụng trong các hệ thống neuromorphic. Mức độ phức tạp tiếp theo là phương pháp Integrate-and-Fire phi tuyến tổng quát, bao gồm mô hình Integrate-and-Fire bậc hai được sử dụng trong một số hệ thống neuromorphic. Một mức độ phức tạp khác được thêm vào mô hình Integrate-and-Fire theo cấp số nhân thích ứng, có độ phức tạp tương tự như các mô hình đã thảo luận ở trên (chẳng hạn như mô hình Izhikevich). Chúng cũng đã được sử dụng trong các hệ thống neuromorphic. Ngoài các mô hình nơ-ron tăng vọt kiểu tương tự (analog), còn có các mô hình nơ-ron tăng vọt kiểu mạch số (digital) cũng được triển khai. Các động lực trong mô hình nơ-ron tăng vọt mạch số thường được điều chỉnh bởi một đơn vị tự động hóa tế bào, trái ngược với một tập hợp các phương trình vi phân tuyến tính hoặc phi tuyến tính. Một triển khai mạch tương tự/số hỗn hợp đã được tạo ra để thực thi hệ thống neuromorphic [30], cũng như thực hiện các nơ-ron tăng vọt kỹ thuật số trên mô hình Resonate-and-Fire [31] và Rotate-and-Fire. Nơ-ron tăng vọt kỹ thuật số cũng đã được sử dụng trong các mạng kết hợp xung (pulse-coupled) [32].

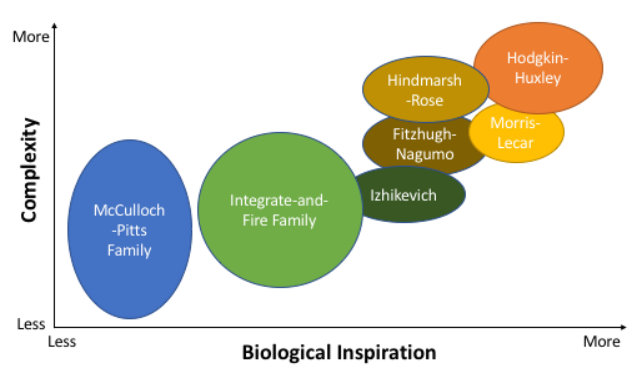

e. Mô hình nơ-ron McCulloch-Pitts: Chuyển sang triển khai mạng nơ-ron nhân tạo truyền thống hơn trong phần cứng, có rất nhiều cách triển khai của mô hình nơ-ron McCulloch-Pitts [20]. Perceptron là một triển khai của mô hình McCulloch-Pitts, sử dụng một hàm ngưỡng đơn giản làm hàm kích hoạt; vì tính đơn giản của nó, nó thường được sử dụng trong triển khai phần cứng [33, 34]. Cũng đã có sự tập trung đáng kể để tạo ra việc triển khai các hàm kích hoạt khác nhau cho các nơ-ron kiểu McCulloch-Pitts trong phần cứng. Các hàm kích hoạt khác nhau có mức độ thành công khác nhau trong tài liệu về mạng nơ-ron và một số hàm kích hoạt có thể đi sâu về mặt tính toán. Sự phức tạp trong tính toán này có thể dẫn đến sự phức tạp trong phần cứng, dẫn đến nhiều hàm kích hoạt và việc thực thi chúng đang đánh đổi độ phức tạp và độ chính xác tổng thể và tính hữu ích của mô hình. Các cách triển khai phổ biến nhất là hàm sigmoid cơ bản và hàm hyperbol tiếp tuyến, nhưng các hàm kích hoạt dựa trên phần cứng khác đã được thực hiện bao gồm hàm bão hòa-độ dốc, tuyến tính, tuyến tính từng đoạn, hàm bước, đa ngưỡng, hàm cơ sở xuyên tâm, hàm sigmoid tiếp tuyến và các hàm kích hoạt tuần hoàn. Một số triển khai đã tập trung vào việc tạo ra các nơ-ron với các hàm kích hoạt có thể lập trình được hoặc vào việc tạo ra các khối xây dựng để cấu tạo các nơ-ron. Các mô hình nơ-ron cho các mô hình mạng nơ-ron nhân tạo truyền thống khác cũng đã được thực hiện trên phần cứng. Các mô hình nơ-ron này bao gồm mạng nơ-ron nhị phân, mạng nơ-ron mờ và mạng nơ-ron Hopfield. Nhìn chung, đã có rất nhiều mô hình nơ-ron được triển khai trên phần cứng và một trong những quyết định mà người dùng có thể đưa ra là sự cân bằng giữa độ phức tạp và cảm hứng sinh học. Hình 3 đưa ra một so sánh định tính của các mô hình nơ-ron khác nhau về hai yếu tố đó.

1.2. Các mô hình khớp thần kinh (synapse)

Cũng giống như một số nghiên cứu về neuromorphic tập trung đặc biệt vào các mô hình nơ-ron, đôi khi các mô hình synapse cũng gói gọn trong việc triển khai synapse, tập trung vào việc phát triển triển khai synapse độc lập với các mô hình nơ-ron cho các hệ thống neuromorphic. Một lần nữa, chúng ta có thể tách các mô hình synapse thành hai loại:

- Triển khai synapse lấy cảm hứng từ sinh học: bao gồm các khớp thần kinh cho các hệ thống tăng vọt.

- Triển khai synapse cho các mạng nơ-ron nhân tạo truyền thống: chẳng hạn như mạng nơ-ron chuyển tiếp.

Điều đáng chú ý là các synapse thường sẽ là phần tử phong phú nhất trong các hệ thống neuromorphic, hoặc là phần tử yêu cầu nhiều tài nguyên nhất trên một con chip. Đối với nhiều triển khai phần cứng và đặc biệt là để phát triển và sử dụng các vật liệu mới cho neuromorphic, trọng tâm thường là tối ưu hóa việc thực hiện synapse. Do đó, các mô hình synapse có xu hướng tương đối đơn giản, trừ khi cố gắng mô hình hóa hành vi sinh học một cách rõ ràng.

Một cách phổ biến cho các mô hình synapse phức tạp hơn là cơ chế dẻo, khiến giá trị độ lớn hoặc trọng số của nơ-ron thay đổi theo thời gian. Cơ chế dẻo đã được phát hiện có liên quan đến quá trình học tập trong não bộ sinh học. Để có thêm các mạng neuromorphic lấy cảm hứng từ sinh học, việc thực thi synapse làm mô hình hóa rõ ràng các tương tác hóa học của các synapse, chẳng hạn như bơm ion hoặc tương tác dẫn truyền thần kinh, đã được sử dụng trong một số hệ thống neuromorphic [35, 36]. Các kênh ion cũng đã được thực hiện trong các triển khai neuromorphic dưới dạng mô hình sysnapse dựa trên độ dẫn [37]. Đối với những triển khai này, chi tiết vượt xa những gì người ta có thể thấy với việc mô hình hóa các kênh ion trong các mô hình nơ-ron như Hodgkin-Huxley.

Việc thực hiện các hệ thống neuromorphic tăng vọt tập trung vào nhiều đặc điểm khác nhau của synapse. Các synapse trong neuromorphic thể hiện tính dẻo và cơ chế học hỏi được lấy cảm hứng từ cả áp lực ngắn hạn và dài hạn và tính suy giảm trong các synapse sinh học vốn đã phổ biến trong các thực thi neuromorphic dựa trên cảm hứng sinh học [38, 39]. Quy tắc điện áp và suy giảm là các dạng cụ thể của quy tắc dẻo phụ thuộc vào thời gian tăng vọt (Spiked-timing Dependent Plasticity – STDP) [40]. Các quy tắc STDP và mạch liên quan của chúng cực kỳ phổ biến trong việc triển khai neuromorphic cho các synapse [41]. Các đáp ứng của synapse cũng có thể tương đối phức tạp trong hệ thống neuromorphic. Một số thực thi synapse trên neuromorphic tập trung vào động lực học của synapse, chẳng hạn như hình dạng của xung tăng vọt đi ra từ synapse hoặc điện thế sau synapse. Các synapse trong hệ thống neuromorphic tăng vọt cũng được sử dụng làm cơ chế cân bằng nội môi để ổn định hoạt động của mạng, đây có thể là một vấn đề trong hệ thống SNN.

Một loạt các thực thi synapse trên neuromorphic cho các mạng nơron không tăng vọt (non-spiking) cũng đã được triển khai. Các mạng này bao gồm các mạng nhiều lớp lan truyền thẳng (feed-forward) [42, 43], Winner-Take-All [44] và mạng nơ-ron tích chập (Convolution Neural Network) [45]. Việc tập trung vào các quy tắc huấn luyện khác nhau cho các synapse trong hệ thống neuromorphic dựa trên mạng nơ-ron nhân tạo cũng rất phổ biến, cũng như đối với STDP và các quy tắc điện áp và suy giảm trong các hệ thống neuromprphic dựa trên tăng vọt. Các quy tắc học phổ biến trong các hệ thống dựa trên mạng nơ-ron nhân tạo bao gồm huấn luyện Hebbian [46] và bình phương tối thiểu [47]. Các synapse Gaussian cũng đã được thực hiện để hỗ trợ các quy tắc huấn luyện lan truyền ngược [48].

1.3. Các mô hình mạng

Các mô hình mạng mô tả cách các nơ-ron và synapse khác nhau được kết nối và cách chúng tương tác. Có rất nhiều mô hình mạng nơ-ron đã được phát triển cho các hệ thống neuromorphic. Chúng đi từ việc cố gắng tái tạo các hoạt động sinh học gần với các mạng nơ-ron không tăng vọt (non-spiking neural network) được tính toán nhiều hơn.

Có nhiều yếu tố cần xem xét khi lựa chọn mô hình mạng.

- Một trong những yếu tố rõ ràng là cảm hứng sinh học và độ phức tạp của các mô hình nơ-ron và mô hình synapse đã thảo luận trong các phần trước.

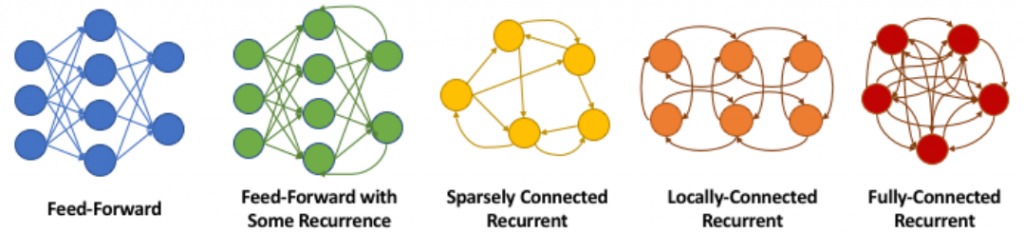

- Một yếu tố khác cần xem xét là cấu trúc liên kết của mạng. Hình 4 cho thấy một số ví dụ về cấu trúc liên kết mạng có thể được sử dụng trong các mô hình mạng khác nhau, bao gồm mạng lấy cảm hứng từ sinh học và mạng tăng vọt. Tùy thuộc vào phần cứng được chọn, kết nối có thể bị tương đối hạn chế, điều này sẽ giới hạn các cấu trúc liên kết khi được triển khai thực tế.

- Yếu tố thứ ba là tính khả thi và khả năng áp dụng của các thuật toán huấn luyện hiện có cho mô hình mạng đã chọn.

- Cuối cùng, khả năng áp dụng chung của mô hình mạng đó cho một tập hợp các ứng dụng cũng có thể đóng một vai trò trong việc lựa chọn mô hình mạng thích hợp.

Có rất nhiều triển khai mạng SNN tổng quát trên phần cứng như trong Hình 4. Những triển khai này sử dụng nhiều mô hình nơ-ron khác nhau, chẳng hạn như các nơ-ron Integrate-and-Fire khác nhau được liệt kê ở trên hoặc các mô hình lấy cảm hứng từ sinh học hoặc các mô hình hợp lý về mặt sinh học. Việc thực hiện mạng SNN bao gồm một số dạng STDP trong việc thực hiện mô hình synapse. Mô hình tăng vọt đã trở nên phổ biến trong việc triển khai neuromorphic, một phần do tính chất điều khiển sự kiện và hiệu quả năng lượng được cải thiện so với các hệ thống khác. Do đó, các mô hình mạng nơ-ron khác đã được tạo ra bằng cách sử dụng các hệ thống neuromorphic tăng vọt (spiking neuromorphic), bao gồm các mạng lan truyền thẳng tăng vọt (spiking feed-forward), các mạng spiking tuần hoàn, các mạng nơ-ron học sâu tăng vọt, hệ thống Hebbian tăng vọt, mạng Spiking Hopfield hoặc bộ nhớ liên tưởng, mạng Spiking Winner-Take-All, mạng xác suất tăng vọt và mạng nơ-ron ngẫu nhiên tăng vọt. Trong những triển khai này, một kiến trúc SNN trong các hệ thống neuromorphic được tối ưu cho một kiểu mô hình mạng nơ-ron khác. Thông thường, việc huấn luyện các phương pháp này được thực hiện trên kiểu mạng nơ-ron truyền thống (chẳng hạn như mạng lan truyền thẳng), và sau đó kết quả giải pháp mạng được điều chỉnh để phù hợp với việc triển khai neuromorphic tăng vọt.

Trong những trường hợp này, các thuộc tính đầy đủ của mạng SNN có thể không được tối ưu hóa. Một mô hình mạng lấy cảm hứng từ sinh học phổ biến thường được triển khai bằng cách sử dụng mạng SNN là bộ tạo mẫu trung tâm (Central Pattern Generator – CPG). CPG tạo ra chuyển động dao động, chẳng hạn như dáng đi hoặc chuyển động bơi trong hệ thống sinh học. Một cách sử dụng phổ biến của CPG là trong chuyển động của robot.

Cách triển khai phổ biến nhất cho đến nay là mạng nơ-ron lan truyền thẳng, bao gồm các perceptron nhiều lớp. Các máy học tăng cường là một trường hợp đặc biệt của mạng nơ-ron lan truyền thẳng, trong đó một số trọng số trong mạng được đặt ngẫu nhiên và không bao giờ được cập nhật dựa trên thuật toán huấn luyện; đã có một số triển khai neuromorphic của máy học tăng cường [49]. Một trường hợp đặc biệt khác của mạng nơ-ron lan truyền thẳng là các perceptron nhiều lớp có độ trễ và chúng cũng đã được triển khai trong các hệ thống neuromorphic. Mạng nơ-ron xác suất, một trường hợp đặc biệt khác của mạng nơ-ron lan truyền thẳng có chức năng cụ thể liên quan đến các phép tính Bayes, có một số triển khai trên neuromorphic. Trong những năm gần đây, với sự gia tăng của học sâu, chúng ta cũng chứng kiến mạng nơ-ron tích chập cũng được triển khai trong các hệ thống neuromorphic [50]. Mạng nơ-ron tuần hoàn là những mạng cho phép thực hiện các chu kỳ trong mạng và chúng có thể có các mức độ kết nối khác nhau, bao gồm tất cả các kết nối. Mạng nơ-ron tuần hoàn không tăng vọt (non-spiking recurrent) cũng đã được thực hiện trong các hệ thống neuromorphic. Tương tự, các triển khai dựa trên bộ nhớ liên tưởng cũng phổ biến hơn đáng kể trong các triển khai neuromprohic trước đó.

Mạng thần kinh ngẫu nhiên, đưa khái niệm ngẫu nhiên vào quá trình xử lý mạng [51]. Một trường hợp đặc biệt của mạng thần kinh ngẫu nhiên – máy Boltzmann, cũng rất phổ biến trong các hệ thống neuromorphic. Máy Boltzmann nói chung đã được sử dụng trong các hệ thống neuromorphic chủ yếu vào đầu những năm 1990 [52]. Hệ thống thị giác là nguồn cảm hứng chung cho các kiểu mạng nơ-ron nhân tạo, bao gồm cả mạng nơ-ron tích chập. Hai mô hình lấy cảm hứng từ hệ thống hình ảnh khác, mạng nơ-ron tế bào và mạng nơ-ron kết hợp xung, đã được sử dụng trong các hệ thống neurommorphic. Các mô hình mạng nơron khác và mạng nơron ít phổ biến hơn được triển khai trong các hệ thống neuromophic bao gồm tự động tế bào, mạng nơ-ron mờ, kết hợp logic mờ và mạng nơ-ron nhân tạo, và bộ nhớ thời gian phân cấp.

Có rất nhiều lựa chọn mô hình cho việc triển khai neuromorphic, và phần lớn nền tảng của các mô hình mạng nơ-ron sinh học và mạng nơ-ron nhân tạo tiềm năng đã từng được nghiên cứu trước đó. Việc lựa chọn mô hình nào sẽ phụ thuộc nhiều vào mục đích của hệ thống neuromorphic. Về tổng thể, hầu hết các mô hình đều đã được triển khai trong phần cứng.

2. Các thuật toán và huấn luyện

Một số câu hỏi mở chủ đạo cho các hệ thống neuromorphic đó là các thuật toán. Mô hình nơ-ron, mô hình synapse và mô hình mạng đã chọn có tác động đến thuật toán được chọn, vì một số thuật toán sẽ cụ thể cho các cấu trúc liên kết mạng, mô hình nơ-ron nhất định hoặc các đặc tính mô hình mạng khác. Ngoài ra, vấn đề thứ hai là việc huấn luyện cho một hệ thống có nên được thực hiện trên chip hay không, hay các mạng nên được huấn luyện ngoài chip sau đó chuyển sang thực thi neuromorphic. Vấn đề thứ ba là liệu các thuật toán có nên thực hiện trực tuyến và không giám sát (trong trường hợp đó, chúng nhất thiết phải được chạy trên chip), liệu các phương pháp ngoại tuyến, có giám sát có đủ hay không hay liệu có nên sử dụng kết hợp cả hai hay không. Một trong những lý do chính khiến các hệ thống neuromorphic được coi là một kiến trúc bổ sung của định luật Moore, đó là tiềm năng của chúng đối với việc học trực tuyến.

2.1. Học có giám sát

Trong học có giám sát, dữ liệu (ngõ vào) được đi kèm với nhãn (mục tiêu) và mục đích của thiết bị học tập là tương quan (các lớp) ngõ vào với ngõ ra mục tiêu (ánh xạ hoặc hồi quy giữa đầu vào và đầu ra). Tín hiệu lỗi được tính toán giữa mục tiêu và ngõ ra thực tế và được sử dụng để cập nhật trọng số của mạng. Học có giám sát cho phép chúng ta sử dụng các mục tiêu để cập nhật trực tiếp các thông số, trong khi học tăng cường chỉ cung cấp cho chúng ta một tín hiệu lỗi chung (phần thưởng) phản ánh hệ thống đang hoạt động tốt như thế nào. Trên thực tế, ranh giới giữa hai hình thức học có giám sát bị xóa nhòa.

Thuật toán được sử dụng phổ biến nhất để lập trình hệ thống neuromorphic là lan truyền ngược (back-propagation). Lan truyền ngược là một phương pháp học có giám sát và thường không được coi là một phương pháp trực tuyến. Lan truyền ngược và nhiều biến thể của nó có thể được sử dụng để lập trình mạng nơ-ron lan truyền thẳng, mạng nơ-ron tuần hoàn, mạng nơ-ron tăng vọt và mạng nơ-ron phức hợp. Cách tiếp cận đơn giản nhất có thể là sử dụng tính năng lan truyền ngược ngoại tuyến trên máy chủ truyền thống, vì có nhiều phần mềm triển khai có sẵn đã được tối ưu hóa cao. Có rất nhiều triển khai về lan truyền ngược trên chip trong các hệ thống neuromorphic, tiêu biểu trong nghiên cứu [53]. Đã có một số công trình nghiên cứu điều chỉnh phương pháp lan truyền ngược cho việc triển khai phần cứng cụ thể của chúng, chẳng hạn như với các đặc tính memristive của synapse [54, 55]. Các phương pháp lan truyền ngược cũng đã được phát triển trong các phương pháp huấn luyện chip-trong-vòng-lặp [56]; trong trường hợp này, hầu hết việc huấn luyện diễn ra trên máy chủ hoặc ngoài chip, nhưng việc đánh giá mạng giải pháp được thực hiện trên chip. Có rất nhiều vấn đề liên quan đến sự lan truyền ngược, bao gồm cả việc nó tương đối hạn chế về loại mô hình nơ-ron, mô hình mạng và cấu trúc liên kết mạng có thể được sử dụng một cách hiệu quả. Nó cũng khó hoặc tốn kém để thực hiện trong phần cứng. Có rất nhiều vấn đề liên quan đến sự lan truyền ngược, bao gồm cả việc nó tương đối hạn chế về loại mô hình nơ-ron, mô hình mạng và giao thức mạng có thể được sử dụng một cách hiệu quả, ngoài ra sẽ khó khăn hoặc tốn kém để thực hiện chúng trên phần cứng. Các phương pháp khác về huấn luyện trọng số có giám sát trên chip cũng đã được tối ưu. Các cơ chế huấn luyện có giám sát trên chip khác được xây dựng cho các loại mô hình cụ thể, chẳng hạn như máy Boltzmann và bộ nhớ thời gian phân cấp.

1.2. Học không giám sát

Dữ liệu được phân phối mà không có nhãn và mạng không nhận được phản hồi nào về hiệu suất của nó. Phát hiện và phản ứng với các tương quan thống kê trong dữ liệu là một hoạt động phổ biến. Việc xác định các mối tương quan có thể là một mục tiêu của chính nó, nhưng nó cũng có thể được sử dụng để phân nhóm hoặc phân loại dữ liệu sau này. STDP được định nghĩa là một quá trình tăng cường trọng số của khớp thần kinh nếu nơ-ron sau synapse hoạt động sớm sau khi nơ-ron trước synapse kích hoạt và làm suy yếu nó nếu nơ-ron sau synapse kích hoạt muộn hơn. Mặt khác, dạng STDP thông thường này chỉ là một trong nhiều dạng STDP sinh học.

Đã có một số nghiên cứu triển khai các cơ chế huấn luyện trên chip, trực tuyến, không có giám sát trong các hệ thống neuromorphic. Các thuật toán huấn luyện tự học này chắc chắn cần thiết để nhận ra tiềm năng đầy đủ của việc triển khai neuromorphic. Một số triển khai neuromorphic ban đầu của học không giám sát dựa trên bản đồ tự tổ chức hoặc các quy tắc học tự tổ chức [57, 58]. Các quy tắc học tập kiểu Hebbian, bao gồm nhiều quy tắc, vốn rất phổ biến như là cơ chế trực tuyến cho các hệ thống neuromorphic và có những biến thể bao gồm cả học tập có giám sát và không giám sát. Cuối cùng, có lẽ cơ chế học trực tuyến, không giám sát phổ biến nhất trong các hệ thống neuromporphic là độ dẻo phụ thuộc vào thời gian tăng vọt [59], đó là một hình thức học tập giống-Hebbian vốn đã được quan sát trong các hệ thống sinh học thực [60]. Quy tắc cho STDP nói chung là nếu một nơ-ron trước synapse kích hoạt ngay trước (sau) nơ-ron sau synapse, thì trọng số của synapse sẽ tăng lên (giảm xuống) và khi thời gian giữa các lần kích hoạt càng ít thì biên độ thay đổi càng cao. Còn có các mạch tùy chỉnh cho sự suy giảm và điện thế trong synapse trong các thực thi mô hình lấy cảm hứng từ sinh học hơn. Cần lưu ý rằng, đặc biệt là đối với STDP, khả năng ứng dụng rộng rãi cho một bộ ứng dụng vẫn chưa được thể hiện một cách đầy đủ. Hệ thống neuromorphic dựa trên mạng nơ-ron tăng vọt đã trở nên phổ biến vì một số lý do, bao gồm hiệu quả về công suất và năng lượng của việc tính toán theo hướng sự kiện của chúng và nguồn cảm hứng sinh học gần gũi hơn của chúng so với mạng nơ-ron nhân tạo nói chung. Mặc dù đã có các phương pháp được đề xuất để huấn luyện mạng nơ-ron tăng vọt thường sẽ tối ưu hóa các quy tắc học STDP để cập nhật trọng số synapse, nhưng toàn bộ khả năng của hệ thống neuromorphic tăng vọt vẫn chưa được thực hiện bằng cơ chế huấn luyện và học tập.

(còn nữa…)

Tác giả: PGS.TS. Lê Đức Hùng, Trường ĐH Khoa học tự nhiên, ĐH Quốc gia TP. HCM.

Biên tập: Quỹ Đổi mới sáng tạo Vingroup (VinIF).

TÀI LIỆU THAM KHẢO

[1]. Schuman, Catherine & Potok, Thomas & Patton, Robert & Birdwell, J. & Dean, Mark & Rose, Garrett & Plank, James., “A Survey of Neuromorphic Computing and Neural Networks in Hardware”, arXiv:1705.06963, 2017.

[2] A. M. Turing, “Computing Machinery and Intelligence,” Mind, Vol. 59, No. 236, pp. 433–460, 1950.

[3] W. S. McCulloch and W. Pitts, “A Logical Calculus of The Ideas Immanent in Nervous Activity,” The bulletin of mathematical biophysics, vol. 5, no. 4, pp. 115–133, 1943.

[4] E. M. Izhikevich, “Which Model to Use for Cortical Spiking Neurons?” IEEE Transactions on Neural Networks, Vol. 15, No. 5, pp. 1063–1070, 2004.

[5] A. L. Hodgkin and A. F. Huxley, “A Quantitative Description of Membrane Current and Its Application to Conduction and Excitation in Nerve,” The Journal of Physiology, Vol. 117, No. 4, pp. 500, 1952.

[6] A. Borisyuk, “Morris–Lecar Model,” in Encyclopedia of Computational Neuroscience. Springer, 2015, pp. 1758–1764.

[7] S. Binczak, S. Jacquir, J.-M. Bilbault, V. B. Kazantsev, and V. I. Nekorkin, “Experimental Study of Electrical Fitzhugh–Nagumo Neurons with Modified Excitability,” Neural Networks, Vol. 19, No. 5, pp. 684–693, 2006.

[8] J. Cosp, S. Binczak, J. Madrenas, and D. Fernandez, “Implementation of Compact VLSI Fitzhugh-Nagumo Neurons,” IEEE International Symposium on Circuits and Systems (ISCAS 2008), pp. 2370–2373, 2008.

[9] B. Linares-Barranco, E. Sanchez-Sinencio, A. Rodriguez-Vazquez, and J. L. Huertas, “A CMOS Implementation of Fitzhugh-Nagumo Neuron Model,” IEEE Journal of Solid-State Circuits, Vol. 26, No. 7, pp. 956–965, 1991.

[10] Y. J. Lee, J. Lee, Y.-B. Kim, J. Ayers, A. Volkovskii, A. Selverston, H. Abarbanel, and M. Rabinovich, “Low-power Real time Electronic Neuron VLSI Design using Subthreshold Technique,” Proceedings of the 2004 International Symposium on Circuits and Systems (ISCAS’04), Vol. 4, pp. IV.744-IV.747, 2004.

[11] J. Lu, Y.-B. Kim, and J. Ayers, “A Low power 65nm CMOS electronic neuron and synapse design for a biomimetic micro-robot,” 2011 IEEE 54th International Midwest Symposium on Circuits and Systems (MWSCAS), pp. 1–4, 2011.

[12] A. Basu, “Small-signal Neural Models and Their Applications,” IEEE Transactions on Biomedical Circuits and Systems, Vol. 6, No. 1, pp. 64–75, 2012.

[13] N. Mizoguchi, Y. Nagamatsu, K. Aihara, and T. Kohno, “A two-variable silicon neuron circuit based on the Izhikevich model,” Artificial Life and Robotics, Vol. 16, No. 3, pp. 383–388, 2011.

[14] O. O. Dutra, G. D. Colleta, L. H. Ferreira, and T. C. Pimenta, “A subthreshold halo implanted MOS implementation of Izhikevich neuron model,” SOI-3D-Subthreshold Microelectronics Technology Unified Conference (S3S), pp. 1–2, 2013.

[15] S. Mihalas¸ and E. Niebur, “A generalized linear Integrate-and-Fire neural model produces diverse spiking behaviors,” Neural computation, Vol. 21, No. 3, pp. 704–718, 2009.

[16] F. Folowosele, R. Etienne-Cummings, and T. J. Hamilton, “A CMOS switched capacitor implementation of the Mihalas-Niebur neuron,” IEEE Biomedical Circuits and Systems Conference (BioCAS 2009), pp. 105–108, 2009.

[17] F. Folowosele, T. J. Hamilton, and R. Etienne-Cummings, “Silicon modeling of the Mihalas–Niebur neuron,” IEEE Transactions on Neural Networks, Vol. 22, No. 12, pp. 1915–1927, 2011.

[18] F. Grassia, T. Levi, T. Kohno, and S. Saighi, “Silicon neuron: digital hardware implementation of the quartic model,” Artificial Life and Robotics, Vol. 19, No. 3, pp. 215–219, 2014.

[19] J. V. Arthur and K. Boahen, “Silicon neurons that inhibit to synchronize,” Proceedings of IEEE International Symposium on Circuits and Systems (ISCAS 2006), pp. 1-4, 2006.

[20] A. Basu and P. E. Hasler, “Nullcline-based design of a silicon neuron,” IEEE Transactions on Circuits and Systems I: Regular Papers, Vol. 57, No. 11, pp. 2938–2947, 2010.

[21] J. G. Elias, H.-H. Chu, and S. M. Meshreki, “Silicon implementation of an artificial dendritic tree,” International Joint Conference on Neural Networks (IJCNN), Vol. 1, pp. 154–159, 1992.

[22] M. Hayati, M. Nouri, S. Haghiri, and D. Abbott, “A Digital Realization of Astrocyte and Neural Glial Interactions,” IEEE Transactions on Biomedical Circuits and Systems, Vol. 10, No. 2, pp. 518-529, 2016.

[23] O. Erdener and S. Ozoguz, “A New Neuron Model Suitable for Low Power VLSI Implementation,” 9th International Conference on Electrical and Electronics Engineering (ELECO), pp. 15–19, 2015.

[24] A. Upegui, C. A. Pena-Reyes, and E. Sanchez, “A Functional Spiking Neuron Hardware Oriented Model,” Computational Methods in Neural Modeling, Springer, pp. 136–143, 2003.

[25] T. Kohno, J. Li, and K. Aihara, “Silicon Neuronal Networks towards Brain-morphic Computers,” Nonlinear Theory and Its Applications, IEICE, Vol. 5, No. 3, pp. 379–390, 2014.

[26] E. Farquhar and P. Hasler, “A bio-physically inspired silicon neuron,” IEEE Transactions on Circuits and Systems I: Regular Papers, Vol. 52, No. 3, pp. 477–488, 2005.

[27] T. Kohno and K. Aihara, “A mathematical-structure-based aVLSI silicon neuron model,” Proceedings of the 2010 International Symposium on Nonlinear Theory and its Applications, pp. 261–264, 2010.

[28] G. Massobrio, P. Massobrio, and S. Martinoia, “Modeling and simulation of silicon neuron-to-isfet junction,” Journal of Computational Electronics, Vol. 6, No. 4, pp. 431–437, 2007.

[29] L. Wen-peng, C. Xu, and L. Hua-xiang, “A New Hardware-oriented Spiking Neuron Model Based on SET and Its Properties,” Physics Procedia, Vol. 22, pp. 170–176, 2011.

[30] S. Hashimoto and H. Torikai, “A novel hybrid spiking neuron: Bifurcations, responses, and on-chip learning,” IEEE Transactions on Circuits and Systems I: Regular Papers, Vol. 57, No. 8, pp. 2168–2181, 2010.

[31] T. Hishiki and H. Torikai, “Bifurcation analysis of a Tesonate-and-Fire type digital spiking neuron,” in Neural Information Processing, Springer, pp. 392–400, 2009.

[32] H. Torikai, H. Hamanaka, and T. Saito, “Reconfigurable digital spiking neuron and its pulse-coupled network: Basic characteristics and potential applications,” IEEE Transactions on Circuits and Systems II: Express Briefs, Vol. 53, No. 8, pp. 734–738, 2006.

[33] S. Aunet, B. Oelmann, S. Abdalla, and Y. Berg, “Reconfigurable subthreshold CMOS perceptron,” IEEE International Joint Conference on Neural Networks, Vol. 3, pp. 1983–1988, 2004.

[34] S. Aunet, B. Oelmann, P. A. Norseng, and Y. Berg, “Real-time reconfigurable subthreshold CMOS perceptron,” IEEE Transactions on Neural Networks, Vol. 19, No. 4, pp. 645–657, 2008.

[35] C. Gordon, A. Preyer, K. Babalola, R. J. Butera, and P. Hasler, “An artificial synapse for interfacing to biological neurons,” IEEE International Symposium on Circuits and Systems (ISCAS 2006), pp. 1-4, 2006.

[36] A. Kazemi, A. Ahmadi, S. Alirezaee, and M. Ahmadi, “A modified synapse model for neuromorphic circuits,” IEEE 7th Latin American Symposium on Circuits & Systems (LASCAS 2o16), pp. 67-70, 2016.

[37] C. Rasche and R. J. Douglas, “Silicon synaptic conductances,” Journal of Computational Neuroscience, Vol. 7, No. 1, pp. 33–39, 1999.

[38] S. Ramakrishnan, P. E. Hasler, and C. Gordon, “Floating gate synapses with spike-time-dependent plasticity,” IEEE Transactions on Biomedical Circuits and Systems, Vol. 5, No. 3, pp. 244-252, 2011.

[39] M. Suri, V. Sousa, L. Perniola, D. Vuillaume, and B. DeSalvo, “Phase change memory for synaptic plasticity application in neuromorphic systems,” The 2011 International Joint Conference on Neural Networks (IJCNN), pp. 619–624, 2011.

[40] Y. Dan and M.-m. Poo, “Spike timing-dependent plasticity of neural circuits,” Neuron, Vol. 44, No. 1, pp. 23–30, 2004.

[41] S. Ambrogio, S. Balatti, F. Nardi, S. Facchinetti, and D. Ielmini, “Spike-timing dependent plasticity in a transistor-selected resistive switching memory,” Nanotechnology, vol. 24, no. 38, pp. 384012, 2013.

[42] H. Chible, “Analog circuit for synapse neural networks VLSI implementation,” The 7th IEEE International Conference on Electronics, Circuits and Systems (ICECS 2000), Vol. 2, pp. 1004-1007, 2000.

[43] C. Diorio, P. Hasler, B. A. Minch, and C. A. Mead, “A single-transistor silicon synapse,”, IEEE Transactions on Electron Devices, Vol. 43, No. 11, pp. 1972–1980, 1996.

[44] S. Yu, “Orientation classification by a winner-take-all network with oxide RRAM based synaptic devices,” IEEE International Symposium on Circuits and Systems (ISCAS 2014), pp. 1058–1061, 2014.

[45] E. Vianello, D. Garbin, O. Bichler, G. Piccolboni, G. Molas, B. De Salvo, and L. Perniola, “Multiple binary OxRAMs as synapses for convolutional neural networks,” Advances in Neuromorphic Hardware Exploiting Emerging Nanoscale Devices, Springer, pp. 109–127, 2017.

[46] H. Card, C. Schneider, and W. Moore, “Hebbian plasticity in MOS synapses,” IEE Proceedings F (Radar and Signal Processing), IET, Vol. 138, No. 1, pp. 13–16, 1991.

[47] V. Srinivasan, J. Dugger, and P. Hasler, “An adaptive analog synapse circuit that implements the least-mean-square learning rule,” IEEE International Symposium on Circuits and Systems (ISCAS 2005), pp. 4441–4444, 2005.

[48] J. Choi, B. J. Sheu, and J.-F. Chang, “A Gaussian synapse circuit for analog VLSI neural networks,” IEEE Transactions on Very Large Scale Integration (VLSI) Systems, Vol. 2, No. 1, pp. 129–133, 1994.

[49] A. Basu, S. Shuo, H. Zhou, M. H. Lim, and G.-B. Huang, “Silicon spiking neurons for hardware implementation of extreme learning machines,” Neurocomputing, Vol. 102, pp. 125–134, 2013.

[50] S. Chakradhar, M. Sankaradas, V. Jakkula, and S. Cadambi, “A dynamically configurable coprocessor for convolutional neural networks,” ACM SIGARCH Computer Architecture News, Vol. 38, No. 3, pp. 247–257, 2010.

[51] E. Neftci, “Stochastic neuromorphic learning machines for weakly labeled data,” 2016 IEEE 34th International Conference on Computer Design (ICCD), pp. 670–673, 2016.

[52] H. Pujol, J. Klein, E. Belhaire, and P. Garda, “RA: An analog neurocomputer for the synchronous Boltzmann machine,” The Fourth International Conference on Microelectronics for Neural Networks and Fuzzy Systems, pp. 449–455, 1994.

[53] M. A. Nuno-Maganda, M. Arias-Estrada, C. Torres-Huitzil, and B. Girau, “Hardware implementation of spiking neural network classifiers based on backpropagation-based learning algorithms,” International Joint Conference on Neural Networks (IJCNN 2009), pp. 2294–2301, 2009.

[54] D. Negrov, I. Karandashev, V. Shakirov, Y. Matveyev, W. DuninBarkowski, and A. Zenkevich, “An approximate backpropagation learning rule for memristor based neural networks using synaptic plasticity,” Neurocomputing, 2016.

[55] M. Ueda, Y. Nishitani, Y. Kaneko, and A. Omote, “Back-propagation operation for analog neural network hardware with synapse components having hysteresis characteristics,” PLoS ONE, Vol. 9, No. 11, p. 112, 2014.

[56] J. Yang, M. Ahmadi, G. A. Jullien, and W. C. Miller, “An in the-loop training method for vlsi neural networks,” IEEE International Symposium on in Circuits and Systems (ISCAS’99), Vol. 5. pp. 619–622, 1999.

[57] I. G. Yu, Y. M. Lee, S. W. Yeo, and C. H. Lee, “Design on supervised/unsupervised learning reconfigurable digital neural network structure,” PRICAI 2006: Trends in Artificial Intelligence, Springer, pp. 1201–1205, 2006.

[58] Y. Arima, K. Mashiko, K. Okada, T. Yamada, A. Maeda, H. Kondoh, and S. Kayano, “A self-learning neural network chip with 125 neurons and 10 k self-organization synapses,” IEEE Journal of Solid-State Circuits, Vol. 26, No. 4, pp. 607–611, 1991.

[59] J. Schemmel, D. Bruderle, A. Grubl, M. Hock, K. Meier, and S. Millner, “A wafer-scale neuromorphic hardware system for largescale neural modeling,” IEEE International Symposium on in Circuits and Systems (ISCAS 2010), pp. 1947–1950, 2010.

[60] J. Sjostrom and W. Gerstner, “Spike-timing dependent plasticity,” Spike-timing dependent plasticity, vol. 35, 2010.